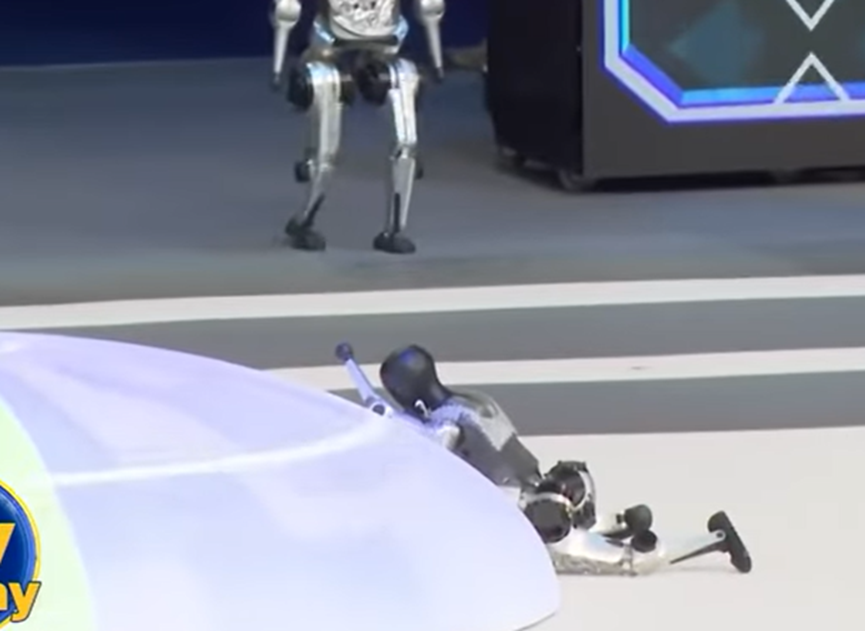

近月多段来自中国本土科技展、商演舞台的 AI/机器人展示影片在社群流传,有的在高调亮相中失灵卡顿、被技术人员「抱离舞台」,有的动作失序,甚至对人员做出不安全的挥臂姿势,引发现场惊呼。虽然这些场合多属民用展演,与军用规格不同,但事件迅速被舆论对照到「93阅兵」中被大力宣传的「人机协同」「智能机器人」等概念——如果连低风险、环境可控的舞台都未能确保稳定与安全,军用场景的高风险、高对抗环境又凭什么保证可靠?

官方媒体对阅兵中的「智能化步兵装备」「机器狗配载」着墨不少,画面里四足平台负载传感器、携行弹药包穿越障碍,评论称「提升城市巷战透渗能力」。但工程领域人士直言,面向真实作战,机器人要通过的门坎远高于「能走」「能看」:在 GPS 受限、磁罗盘飘移、无线链路受压、目标扰动复杂的情况下,导航、避障、抓取与射击等动作要保证确定性与安全性,需要长期的场景数据、边界条件测试与冗余设计,远不是一次秀场可以跨越。

【技术风险盘点】

人机互动安全:

若控制器或传感器输出出现抖动、延迟或漂移,机械臂与四足平台就可能作出不可预期动作。军用环境中,与队友、非战斗员的距离管理与碰撞风险控制,涉及严格的功能安全(FuSa)设计与 SIL/ASIL 等级评估,非演示可替代。

感知数据质量与偏差:

探测器在强光、烟雾、反射、遮挡与对手投放的欺骗纹理下容易错判;若数据校准不足,模型场景迁移不佳,一旦从「干净舞台」走向「肮脏战场」,误检漏检激增,后果不堪设想。

韧体与更新治理:

机器人高度依赖软件更新迭代,但军事任务要求「可追溯、可回退、可验证」;一套 CI/CD 体系与型号管理必须受控且可审计。展演常见的「临时打补丁」「现场调参」在战场上是禁忌。

任务伦理与越权防护:

一旦上载武器,AI 决策的越权防护、目标识别阈值、停火机制、争议场景的人为复核,是不可跳过的「红线设计」。目前公开展示少见对此的透明说明。

【产业与供应链的「政治任务化」】

多名地方科技园区人士透露,近年来「智能化装备」被列为考核亮点,地方部门为追求「可视化成果」偏好外形炫目、上镜效果佳的原型,导致资金与研发被扭向「形象工程」。在预算紧、周期短、考核硬的三重压力下,「可演示」压过「可战用」——这种倾向若延伸到军工,无异于把风险搬上前线。

【社论:从秀场事故到作战安全,必须补齐的四道关卡】

第一,从演示指标转向安全指标:以 MTBF(平均无故障时间)、FMEA(失效模式影响分析)与安全案例库替代「动作花哨」「队形整齐」的表演评分。

第二,从单机能力转向体系韧性:确保失联、失校、失效时的降级模式与接管机制,避免「一处失准、全局崩溃」。

第三,从黑箱决策转向可验证:对关键算法建立可审计、可测试的验证管线,避免「撞大运式」成功。

第四,从追热点转向打地基:数据治理、仿真平台、场景库与工业级测试,是真实战力的地基。

93阅兵把 AI 机器人推上聚光灯,但战力不是把摄像机对准硬件就能获得。若决策层继续以「可上镜」作为资源分配标尺,秀场翻车的尴尬,只会在更严酷的战场重演——代价远高于被人群嘲。